基于视觉的无人机自动着陆定位算法

摘要:本文提出了一种基于HSV直方图、椭圆拟合和多边形拟合的着陆目标提取和位姿估计的算法,提出了一种特定颜色、特定形状的新型地标。充分应用颜色信息和几何信息,消除了特征点检测出现错误匹配的情况,对光照及目标模型旋转均有一定鲁棒性,有效提高了目标检测的速度和准确度。本文通过坐标变换以及椭圆的基本特征,将位姿估计转化为一个一元十二次方程的求解问题,并对坐标转换进行简化处理,提高位姿估计的处理速度。最后通过实拍测试,证明本文的方法可靠、目标可识别及降落位置准确。

本文引用地址:http://www.amcfsurvey.com/article/201606/293261.htm引言

在机器人研究领域里,无人机系统已经成为一个主要趋势, 在无人机降落过程中,对降落目标的识别以及无人机位姿估计是两个至关重要的问题。文献[3]中采用net-Recovery方法,系统整体分为地面系统和无人机搭载系统。无人机搭载系统负责图像采集以及控制无人机的飞行,通过GPS和IMU收集位置信息;地面系统负责图像处理,获取基于视觉的位置和速度评估值。文献[2]中设计了一种新型降落目标模型,充分应用到几何特性。由此篇文章的启发,本文中也自主设计了一种易于识别的模型,在识别之后,先将目标区域进行分割,然后再进行无人机位姿估计。文献[5]中的设计是基于文献[2]中设计的目标识别的改进,考虑到了光线及遮挡问题,提取效果较好,增强了目标识别的鲁棒性。文献[6]提出了一种新型着陆模型,用到同心圆图形比例关系,但没有给出侧方检测出椭圆时的处理方法。文献[1]和文献[4]中都提出了一种目标分割的方法和流程。文献[1]中应用到了直方图均衡、图像分块匹配及CamShift算法提取图像轮廓。而本文应用彩色直方图分割,先确定图像中是否有降落目标,再通过椭圆拟合和椭圆分割,将目标图像分割出来,然后再通过坐标转换,将位置估计转化为一个一元十二次方程的求解问题。

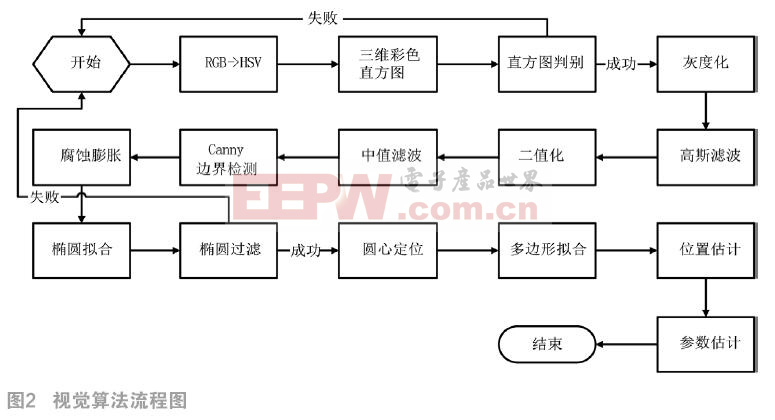

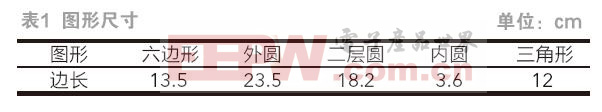

本文采用一种新型着陆目标,如图1所示,本图形由一个六边形、三个同心圆和一个等边三角形组成,每个图形的边长如表1所示。每个图形与其外围图形之间有颜色区分,着陆目标大部分都为红色,少部分为白色。视觉算法流程图如图2所示。

1 基于彩色直方图及椭圆拟合的目标提取

本文采用HSV颜色模式,通常采集的图片颜色模式为RGB,但是RGB模式对颜色的失真度较大,所以首先将RGB模式转为HSV模式,其中H代表色相,通过公式1求取红色像素个数。

(1)

(1)

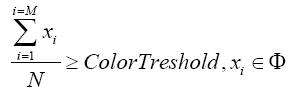

其中M为红色像素个数,N为总像素个数。当比例满足一定阈值时,我们认为图像中有要寻找的着陆目标;否则,直接进行下一帧图像检索,如公式(1)所示。考虑到目标远近及角度问题,其中阈值我们取0.05。

初步预判图像中是否有着陆目标后,采用边缘识别比较优秀的Canny边缘检测算法进行检测。为了防止边界细小并且出现细小的断续,我们采用膨胀腐蚀方法对图像进行处理。先做膨胀,使图形闭合,再做腐蚀,消除膨胀后边界过粗现象。

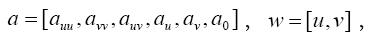

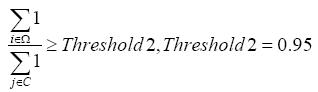

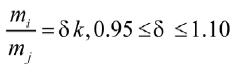

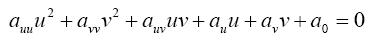

边缘检测好后,我们采用最小二乘法进行椭圆拟合,椭圆的表达式如公式(2)所示。其中包括六个位置参数,令 求出椭圆参数。求出的椭圆方程满足所有边界点与其距离差方和最小。接下来通过椭圆过滤,滤掉不规则的外部边界以及着陆目标中非椭圆部分。在拟合出的椭圆中会得到长半轴和短半轴长度m和n,这里我们将m和n的范围同时扩大或缩小相同的倍数,使得一个椭圆变成一个椭圆簇,椭圆簇中每个椭圆的旋转角度相同,两个焦点坐标相同,短半轴与长半轴的比例相同,即满足公式(2)的关系。本文中设在0.85~1.15之间,同时我们计算满足公式(2)的点数占边缘点数的比例,比例范围在一定区间的椭圆才确定是我们需要检测出的边缘,如表达式(3)所示。本文中设为0.95。因为我们所选择的图形椭圆比例固定,并且圆映射后其半径会映射为椭圆的长半轴长度,在检测出的椭圆中我们需要进行不同椭圆长半轴之间比值判断,这里我们只判断外圆和第二层圆的比值,而内部圆形用于圆心的定位,比例如公式(4)所示,δ范围为0.95~1.10。

求出椭圆参数。求出的椭圆方程满足所有边界点与其距离差方和最小。接下来通过椭圆过滤,滤掉不规则的外部边界以及着陆目标中非椭圆部分。在拟合出的椭圆中会得到长半轴和短半轴长度m和n,这里我们将m和n的范围同时扩大或缩小相同的倍数,使得一个椭圆变成一个椭圆簇,椭圆簇中每个椭圆的旋转角度相同,两个焦点坐标相同,短半轴与长半轴的比例相同,即满足公式(2)的关系。本文中设在0.85~1.15之间,同时我们计算满足公式(2)的点数占边缘点数的比例,比例范围在一定区间的椭圆才确定是我们需要检测出的边缘,如表达式(3)所示。本文中设为0.95。因为我们所选择的图形椭圆比例固定,并且圆映射后其半径会映射为椭圆的长半轴长度,在检测出的椭圆中我们需要进行不同椭圆长半轴之间比值判断,这里我们只判断外圆和第二层圆的比值,而内部圆形用于圆心的定位,比例如公式(4)所示,δ范围为0.95~1.10。

(2)

(2)

(3)

(3)

(4)

(4)

当椭圆确定后,因为范围大的椭圆对圆心估计的失真较大,所以我们根据识别出来的最小椭圆来判定圆心坐标,同时根据外圆半径与六边形的比例关系,可以确定着陆目标的范围,通过基于Ramer–Douglas–Peucker(RDP)算法多边形拟合,可以降低曲线中的点数,只保留顶点坐标,通过判定顶点坐标是否全部都在预先确定的着陆目标范围内而排除干扰图形。其中顶点坐标范围判别如公式(5)所示,L为六边形顶点到圆心距离,为阈值,设为1.2。

![]() (5)

(5)

通过以上公式,可以提取出六边形和三角形,并且过滤掉外围干扰边缘。

2 位置估计及参数估计

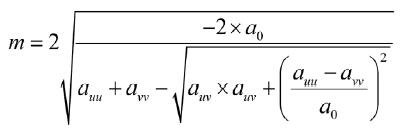

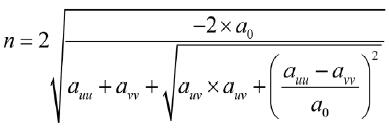

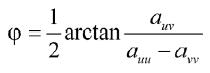

当我们得到椭圆方程后,根据外圆的参数,可以得到长短半轴与坐标轴平行时椭圆的横滚角为 、长半轴长为m,短半轴长为n,如公式(6)~(8)所示。空间位置具有六个自由度,即

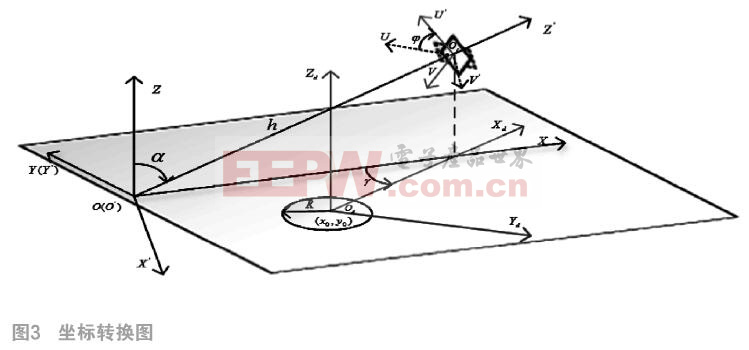

、长半轴长为m,短半轴长为n,如公式(6)~(8)所示。空间位置具有六个自由度,即![]() ,其中V是无人机相对于着陆目标原点的空间位置坐标,R是无人机相对于着陆目标原点的角度坐标,ad为俯仰角,gd为偏航角,jd为横滚角。其中,jd可以通过椭圆参数求得的j直接得出,而其他五个参数可以通过坐标转换得出,各坐标系之间的关系如图3所示。

,其中V是无人机相对于着陆目标原点的空间位置坐标,R是无人机相对于着陆目标原点的角度坐标,ad为俯仰角,gd为偏航角,jd为横滚角。其中,jd可以通过椭圆参数求得的j直接得出,而其他五个参数可以通过坐标转换得出,各坐标系之间的关系如图3所示。

(6)

(6)

(7)

(7)

(8)

(8)

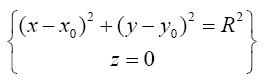

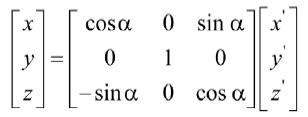

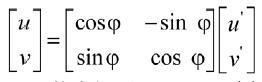

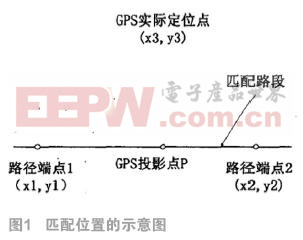

在摄像机拍摄的图像中,设光心与地面交点为原点O,光轴在水平面投影为X轴,水平面上与X轴垂直的为Y轴,与水平面垂直的为Z轴,以O为坐标原点的地面坐标系为OXYZ。以Y轴为旋转轴,将OXZ平面旋转α角,使Z'轴与光轴重合,得到O'X'Y'Z'坐标系。在获取的图像上,我们以图像的中心为坐标原点,图像横向为U轴,图像的纵向为V轴,光心为原点Oc,即图像中心。由于拍摄图像时摄像机会有一定的横滚角j,即椭圆与图像U轴的夹角,让坐标系OCUV旋转j角度,使横滚角为0℃,旋转后的坐标轴为O'CU'V',坐标系O'CU'V'为坐标系O'X'Y'Z'的投影。令OOC长度为h,圆心在OXYZ中的坐标为(x0,y0),大圆的半径已知为R。

地面坐标系中,圆的方程如公式(9)所示;坐标系OXYZ与坐标系O'X'Y'Z'的转换关系如公式(10)所示;坐标系OCUV与坐标系O'CU'V'的转换关系如公式(11)所示。

(9)

(9)

(10)

(10)

(11)

(11)

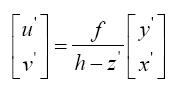

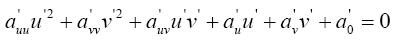

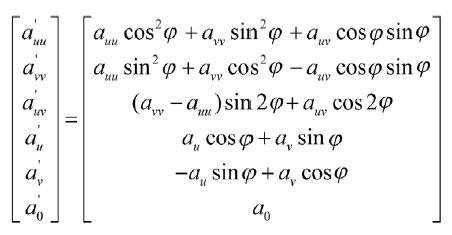

从坐标系O'X'Y'Z'到坐标系O'CU'V'的映射满足小孔成像映射原理,其映射表达式如(12)所示,其中f为摄像机焦距。图像中椭圆的一般方程表达式如(13)所示,由坐标系OCUV旋转 角得到坐标系O'CU'V'后,椭圆的表达式如(14)所示,由表达式(9)、(10)、(11)、(12)和(14)解得椭圆方程的参数如(15)所示。

角得到坐标系O'CU'V'后,椭圆的表达式如(14)所示,由表达式(9)、(10)、(11)、(12)和(14)解得椭圆方程的参数如(15)所示。![]() 已知,

已知, 角可直接由公式(8)求得,所以由(13)可求得O'CU'V'坐标系中椭圆方程的参数如公式(17)所示。

角可直接由公式(8)求得,所以由(13)可求得O'CU'V'坐标系中椭圆方程的参数如公式(17)所示。

(12)

(12)

(13)

(13)

(14)

(14)

(15)

(15)

(16)

(16)

(17)

(17)

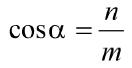

联立(15)和(17),并令![]() 得关于x的一元十二次方程, 将j由公式(8)求得值带入公式(17)中求

得关于x的一元十二次方程, 将j由公式(8)求得值带入公式(17)中求 的值,椭圆短半轴与长半轴的比值是COSα,将

的值,椭圆短半轴与长半轴的比值是COSα,将 和α值带入(15)中,可求出的值。

和α值带入(15)中,可求出的值。

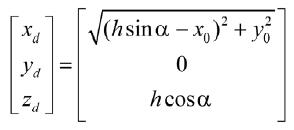

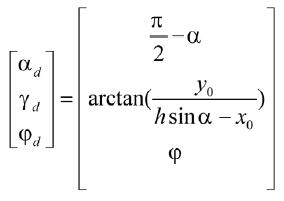

图3中我们令坐标系OdXdYdZd以圆心为原点,以OdOc轴在水平面投影方向为Xd轴,以Xd轴垂直方向为Yd轴,以垂直水平面方向向上为Zd轴,光心在OdXdYdZd坐标系中的位置为 ,如公式(18),俯仰角、偏航角和横滚角

,如公式(18),俯仰角、偏航角和横滚角 可如公式(19)解得。至此无人机的六个自由度

可如公式(19)解得。至此无人机的六个自由度![]() 都已求出。

都已求出。

(18)

(18)

(19)

(19)

3 实验结果

3.1 不同角度和光线下目标提取效果

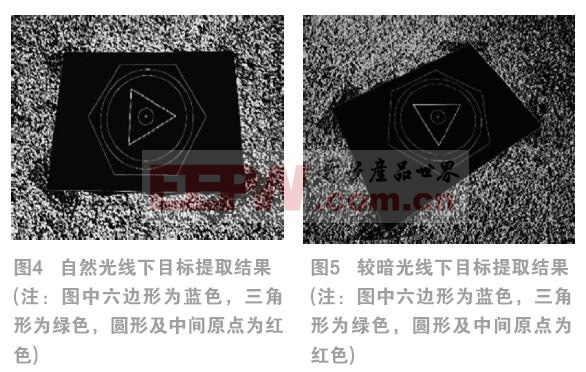

在室外通过无人机拍摄,将摄像机固定在无人机下方,获取不同光照条件下地标图形,图4是在普通自然光下地标提取效果图,图5为在光照较暗的条件下提取的效果。

在自然光和阴暗条件下,通过不同角度拍摄,目标识别效果均比较理想,可以排除噪点的影响。红色部分为改进的椭圆拟合提取的椭圆图形,蓝色和绿色部分为多边形拟合提取的结果,多边形拟合过程中会对三角形和六边形做不同的处理,以充分识别多边形的形状,中间的红色原点为识别出来的圆心位置。可见本文目标提取算法可以准确提取目标,可以有效排除周围噪点的干扰,在不同光线和拍摄角度下提取效果均比较理性,可见本文算法具有良好的稳定性。

3.2 基于椭圆和多边形的位姿估计

表2和表3分别是在自然光和光线较暗的条件下的位姿估计结果。拍摄高度在40cm~180cm范围,水平距离在20cm~200cm范围内,横滚角控制在20°以内,偏航角在50°以内,俯仰角30°~80°之间,实验结果比较准确,但是在俯仰角较小而偏航角较大的情况下误差会增大,但仍能控制在5cm范围内,说明本文能够满足无人机定位的要求。

4 总结

本文设计了一个新型着陆模型,利用HSV彩色直方图排除无目标图像,通过改善的椭圆拟合和多边形拟合识别着陆目标,识别结果理想,对光照和旋转有很高的鲁棒性。本文通过坐标变换及椭圆方程的性质求得无人机位姿,误差控制在5cm范围内。实验结果充分证明本文方法稳定可行。

参考文献:

[1]Zhao Y, Pei H. An improved vision-based algorithm for unmanned aerial vehicles autonomous landing[J]. Physics Procedia, 2012, 33: 935-941.

[2]Cocchioni F, Mancini A, Longhi S. Autonomous navigation, landing and recharge of a quadrotor using artificial vision[C] Unmanned Aircraft Systems (ICUAS), 2014 International Conference on. IEEE, 2014: 418-429.

[3]Kim H J, Kim M, Lim H, et al. Fully autonomous vision-based net-recovery landing system for a fixed-wing uav[J]. Mechatronics, IEEE/ASME Transactions on, 2013, 18(4): 1320-1333.

[4]Hui C, Yousheng C, Xiaokun L, et al. Autonomous takeoff, tracking and landing of a UAV on a moving UGV using onboard monocular vision[C] Control Conference (CCC), 2013 32nd Chinese. IEEE, 2013: 5895-5901.

[5]Cocchioni F, Frontoni E, Ippoliti G, et al. Visual Based Landing for an Unmanned Quadrotor[J]. Journal of Intelligent & Robotic Systems, 2015: 1-18.

[6]Lange S, Sünderhauf N, Protzel P. Autonomous landing for a multirotor UAV using vision[C] International Conference on Simulation, Modeling, and Programming for Autonomous Robots (SIMPAR 2008). 2008: 482-491.

本文来源于中国科技期刊《电子产品世界》2016年第6期第48页,欢迎您写论文时引用,并注明出处。

评论