AI算法复制人类大脑功能?这种AI正通过三种方式欺骗你!

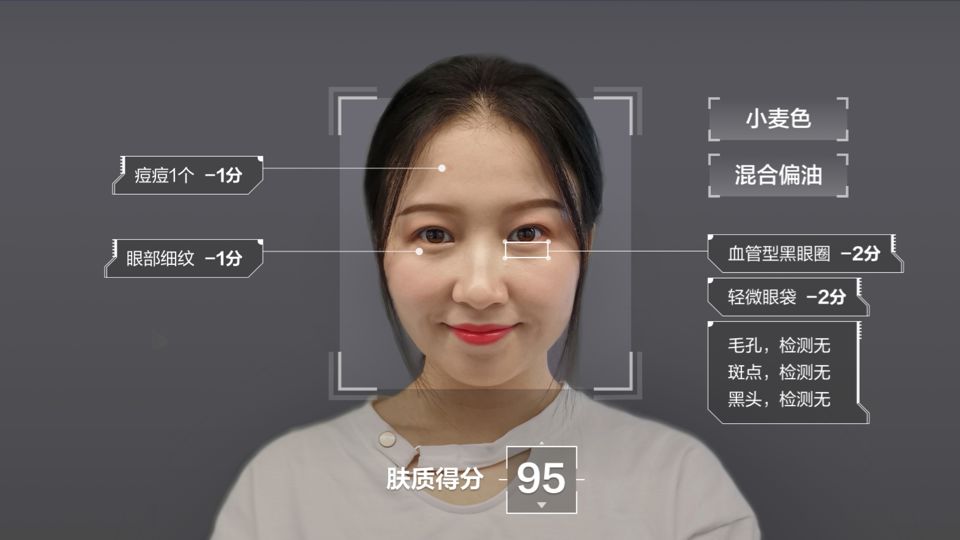

针对人工智能(AI)算法的网络攻击新闻已不再罕见,现在几乎每天都在发生。研究人员发现,无论是在实验室环境还是在实践中,算法都十分脆弱。在许多头条新闻中,我们看到人脸识别系统可能被特殊眼镜和黑客操纵的医疗应用程序欺骗,比如AI癌症诊断系统。

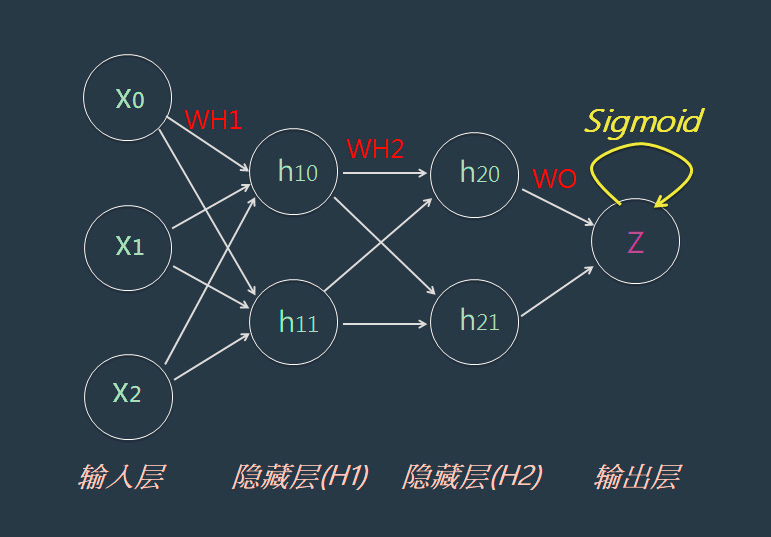

本文引用地址:http://www.amcfsurvey.com/article/201907/403250.htmAI的进步、新神经网络的构成以及神经科学新模型的出现都表明,我们正在接近这样的现实,即AI算法可以复制大脑功能。尽管这些技术还远远不够完美,但AI和人类大脑有许多惊人的相似之处,尤其是在图像处理技术方面。

最近,科学家们发现,黑客不仅可以对神经网络发起对抗性攻击,也可以对人类发起类似攻击。通过某些操作,他们成功地对狗的图像进行了修改,让人们误以为它是猫。然后,科学家们又改变了蛇的图像,使它看起来像蜘蛛,反之亦然。

这项研究之所以引起了我的注意,是因为它提供了很好的例子,我们可以把它付诸实践,检查各种情况下发生欺骗的可能性。这促使我做了个实验,调查人们对这些照片的反应,尤其是那些患有蜘蛛恐惧症的人。喜欢蛇的人(同时也对蜘蛛有很深的恐惧)看到蜘蛛变成蛇的画面会感到不舒服。

然而,当他们意识到照片中的主体确实是蜘蛛时,他们的不安变成了恐惧。这些实验表明,这种类型的对抗性攻击可以在潜意识中发挥作用。也就是说,某个人没有意识到图片有什么问题,就像算法不能识别攻击一样。

因此,当涉及到对抗性攻击和网络安全时,我们必须考虑到,即使是人类的眼睛,这个复杂的器官和长期进化的产物,也无法抵御这种攻击。从这个意义上说,很容易看出对感官的攻击可以与对算法的攻击进行比较。

虽然神经语言程序设计(NLP)还没有得到科学的证实,但对语言或其他感官的对抗性攻击可能与这个领域有关。事实上,对AI的隐私攻击可以被视为吐真药或催眠,让我们研究以下几种AI欺骗人类大脑的示例:

阈下知觉广告

深度学习模型可以通过大量的图像数据集进行训练,从而根据一张照片来识别一个人的信任水平。使用AI进行对抗性攻击可以创建任何人最“可靠”的照片,并提高受众的信任水平。

我们所需要的只是改变一张照片,这样照片才能激发信任。它可以被用于广告,由于照片的快速调整,你会更容易吸引客户青睐!

利用音频

现在,让我们来看看音频信息和语音感知的过程。当我们听到某个词,没有上下文我们无法解释它的意思时,我们经常会在脑海中产生几个猜测。当我们听到一个句子的结尾时,我们的大脑会固定信息,并推断出某个单词的最终含义。这种机制类似于递归神经网络中基于注意力的模型。

在我们解密信息之前,没有上下文存在的所有含义都会在某种程度上被下意识地处理掉,它们会对我们的思维产生轻微的影响。如果人类的大脑能够识别由多义词组合而成的句子的不同可能含义,人们就能在不经意的情况下接收到平行乃至互相矛盾的命令。而巨大的数据集可以自动化这个过程,并创建具有隐藏双重含义的文本。

AI支持的测谎仪

我再举个例子——隐私攻击,就是试图揭露某个人隐藏的信息。在交流中,人们倾向于使用面部表情、身体姿势、手势和眼神来推断意思。肢体语言往往能或明或暗地透露说话人的心理状态、情绪和感受。事实上,有许多类似的隐藏数据泄漏通道,如体温、瞳孔大小、辐射水平或人类呼吸出的化学成分。

如果有人构建了一个精确的设备,能够捕捉所有这些隐藏的通道,他们就能读懂人类对外界刺激的反应,比如图像和挑衅的问题。这与神经网络上的隐私攻击类似,攻击者测试不同的输入数据来访问信息。

自我保护措施

对人类的潜意识攻击,如我提到的例子,通常是很可怕的。最糟糕的是,它们不是凭空想象出来的,而且可以在任何时候实施。有了这些建议,你可以武装自己,抵御这些攻击:

——仔细检查你所使用媒体中的所有关键信息,并对你发送的信息进行反复审核;

——学习心理学,并了解大脑是如何工作的,然后把这些知识应用到你每天看到的视觉刺激上;

——不要在社交媒体上发布过多不必要的个人信息,你肯定不希望有额外的数据可以提供给黑客有针对性的信息。

如果将来我们可以戴上特殊的眼镜或助听器来保护自己免受音频或视觉网络攻击,我对此不会感到惊讶。但在此之前,使用这些策略将是非常重要的,尽可能多地了解AI及其不那么光彩的用例,以确保自己和公司的安全。请记住,只要对这些应用有更多的了解,与那些没有相同知识的人相比,就就具备了很大的优势。

评论