蓝海变成红海?AMD在AI领域向英伟达发起挑战!

最近今年随着各种生成式AI的大伙,英伟达着实是风光了好一阵子。作为被大众成为新一代“工业革命”的生成式AI,在现实中虽刚刚进入应用阶段,作为AI训练最优秀的硬件生产商的英伟达,股票可谓是节节高升,面对这一片蓝海,其他厂商不可能不眼红,于是就在前不久(2023年6月13日)英伟达的老对手AMD在数据中心和人工智能首映式上就发布了全新一代AI芯片,号称世界上最强的AI处理芯片。

本文引用地址:http://www.amcfsurvey.com/article/202306/447759.htm

英伟达AI计算平台H100

在会议开始时,AMD 全球总裁兼 CEO 苏姿丰表示:“今天,我们在数据中心战略上又向前迈出了重要一步,因为我们扩展了第四代 EPYC 处理器系列,为云和技术计算工作负载提供了新的领先解决方案,并宣布了与最大的云提供商的新公共实例和内部部署。人工智能是塑造下一代计算的决定性技术,也是 AMD 最大的战略增长机会。我们专注于加速 AMD AI 平台在数据中心的大规模部署,计划于今年晚些时候推出我们的 Instinct MI300 加速器,以及为我们的硬件优化的企业级 AI 软件生态系统不断壮大。”

随后,苏姿丰博士便发布了三款全新的面对数据中心和AI平台的芯片,分别是:新一代的 Epyc 处理器,Bergamo 是针对云原生应用的产品线,也是第一款使用 Zen 4c 架构的产品;最新的缓存堆叠 X 芯片,代号为 Genoa-X,其与具有相同内核数的 Intel Xeon 的比较,性能提高了 2.2 倍和 2.9 倍;新款 GPU 专用的 MI300X AI 加速器,并表示 MI300X 和 8-GPU Instinct 平台将在第三季度出样,并在第四季度推出。我们分别来简要介绍一下。

正如上文所说,Bergamo 是针对云原生应用的产品线,Bergamo所使用的Zen 4c架构是一种“青春版”,进行了一系列的精简,重新设计了L3快取系统,对比完整的Zen 4架构,其芯片面积减少了35%。

在具体规模方面, Bergamo Epyc 处理器具有 最高128 个核心和 256 个线程,分布在八个核心复合芯片上。其中每一个CCD芯片之上,有16个Zen 4c,而一颗Bergamo其上最多集成8个CCD,因此其最高具备128 核心,同时其采用了台积电5nm工艺制造,共有高达 820 亿个晶体管。

AMD Bergamo Epyc 处理器

而Meta将作为Bergamo芯片最先一批客户,Meta计划为其基础架构使用Bergamo,它的性能比上一代 Milan 芯片高出 2.5 倍。Meta 还将使用 Bergamo 作为其存储平台。

接下来便便是AMD推出的Genoa-X,其针对的场景主要是高性能计算,例如:流体力学、分子动力学、有限元分析等等对于带宽要求极高的科学计算应用。为此AMD在Genoa-X CPU 在每个芯片计算芯片上堆叠了 64MB SRAM 块,因此其三级缓存来到了惊人的1.1GB的大小。得益于如此恐怖的三级缓存大小,Genoa-X 与具有相同内核数的 Intel Xeon 的比较,其对于流体力学的计算能力直接提升了2.2倍。

AMD Genoa-X

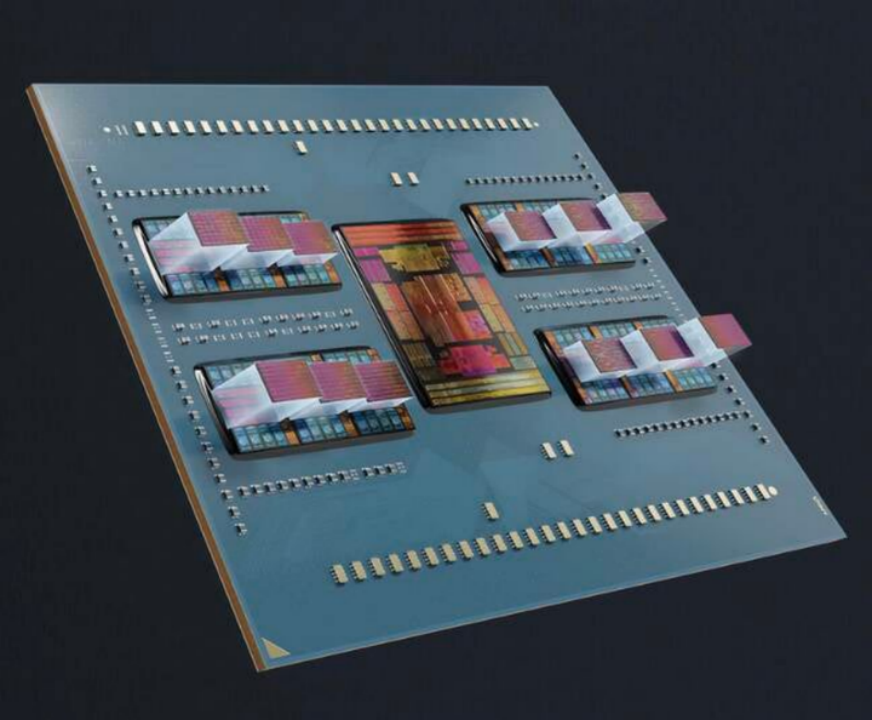

而本次发布会的重磅内容,自然是AMD面向AI的计算平台,Instinct MI300 加速器。它的对标对手,正是近期大红大紫的英伟达“地球最强”GPU计算平台,H100系列。AMD Instinct MI300 于去年 6 月首次发布,并在 2023 年国际消费电子展上进行了更深入的详细介绍,这是 AMD 在 AI 和 HPC 市场的重要一步。

AMD直面英伟达推出的AI计算平台MI300系列

在本次发布会之上,苏姿丰发布了两款MI300系列加速器,分别是MI300A和MI300X。其中,MI300A是“基础款”,MI300X则是硬件性能更高的“大模型优化款”。

我们先来看看MI300A的基本情况,据AMD表示,MI300A是首款AMD面对AI和高性能计算(HPC)推出的APU。它一共拥有13个小芯片,包含9个5nm制程GPU+CPU,以及4个6nm制程的小芯片(base dies),包含1460亿个晶体管,其中有24个Zen 4 CPU核心,1个CDNA 3图形引擎,128GB的HBM3内存。九个计算裸片混合了 5nm CPU 和 GPU,它们以 3D 方式堆叠在四个 6nm 基础裸片之上,这些裸片是处理内存和 I/O 流量以及其他功能的有源中介层。对比与上一代产品MI250,性能提升了8倍,效率提升了5倍。

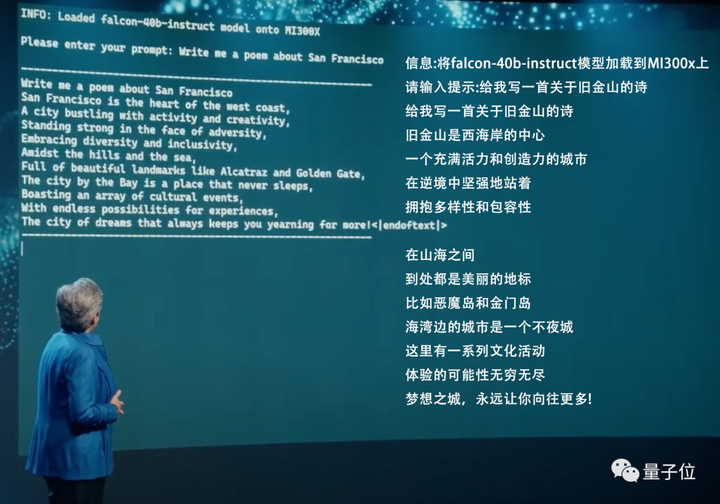

作为重量级产品的MI300X,AMD在PPT上打出了十分令人瞩目的一行字:For LLM——大语言模型专用。AMD表示,MI300X的高带宽内存(HBM)密度,最高可达英伟达H100的2.4倍,高带宽内存带宽最高可达H100的1.6倍,显然MI300X能运行比H100更大的AI模型。在发布会上,苏姿丰博士还现场运行了Hugging Face 的falcon-40b-instruct模型,写了首关于旧金山(这次AMD发布会地址)的小诗,以此来展示MI300X在本地处理大语言模型的强大算力。

在硬件参数方面,MI300X包含12个小芯片,1530亿个晶体管,192GB的HBM3内存,内存带宽达到5.2TB/s,Infinity Fabric带宽达到896GB/s。这次MI300X所提供的HBM密度是对手英伟达H100的2.4倍,HBM带宽则是1.6倍。单单从硬件参数上来看,MI300X无疑是已经超过了英伟达的H100,成为了这个星球上,最强的LLM训练硬件,但是有趣的是,就在MI300系列发布的时刻,资本市场的反应却不是很乐观。

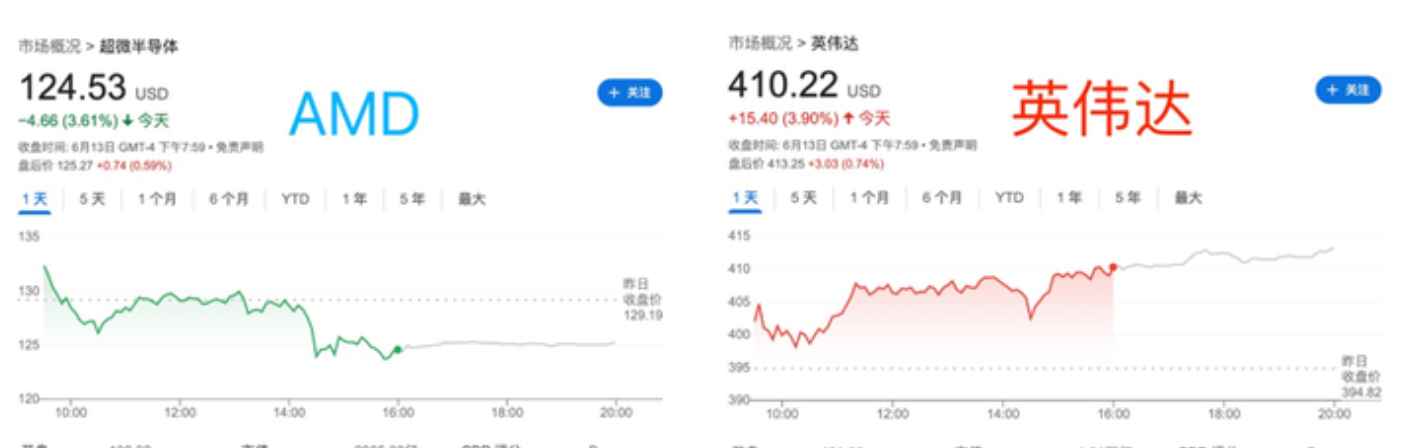

随着发布会的进行,AMD的股票是一跌再跌。跌幅最大的时候一度超过了3.61%,而英伟达这边倒是迎来的一波小小的涨幅。看来对于投资者来说,对于AMD强势发布的MI300系列好像并不是很好看。鉴于AMD这几年来在AI方面的迟缓,再加上MI300X要等到今年年末才有可能被AMD推向市场,这种股价变动,倒也是在意料之中。

不管怎么说,英伟达已经在AI计算领域称王称霸了许久,现在终于有一个实力“靠谱”的新选手上台挑战了,无论结果如何,对于整个市场来说一定是乐于见到的,比起英伟达的一家独大,百家争鸣才是一个良性的环境。

评论