中国疯抢 GPU,这场困局如何破?

在 AI 领域,GPU 的主要应用场景有两个,第一个是训练场景,即利用 GPU 加速 AI 算法的训练。第二个场景是推理场景,即利用 GPU 加速 AI 算法推理。目前,国内高端 AI 场景中的 GPU 应用基本上都由英伟达的 A800 覆盖。

本文引用地址:http://www.amcfsurvey.com/article/202308/449886.htmA800 被视为是 A100 的「阉割版」。去年由于美国政府收紧对华出口管制,英伟达迅速推出数据传输速度相对较慢的 A800,用来代替 A100 向中国出口,与此类似的还有更高端的英伟达 H100 和 H800。

由于中国暂时没有能力提供用于云端 AI 训练的高性能 GPU,因此 A800 迎来中国互联网巨头的青睐。

全球芯片巨头,囤积 GPU

据报道,中国的互联网巨头百度、腾讯、阿里巴巴以及字节跳动公司今年向英伟达下达的交付订单金额达到 10 亿美元,总共采购约 10 万张 A800 芯片;明年交付的 AI 芯片价值更是达到 40 亿美元。

可见,中国大型科技公司对于 GPU 采购非常急迫。不止国内企业,国外大客户对英伟达的 A100/H100 芯片需求同样非常强烈。

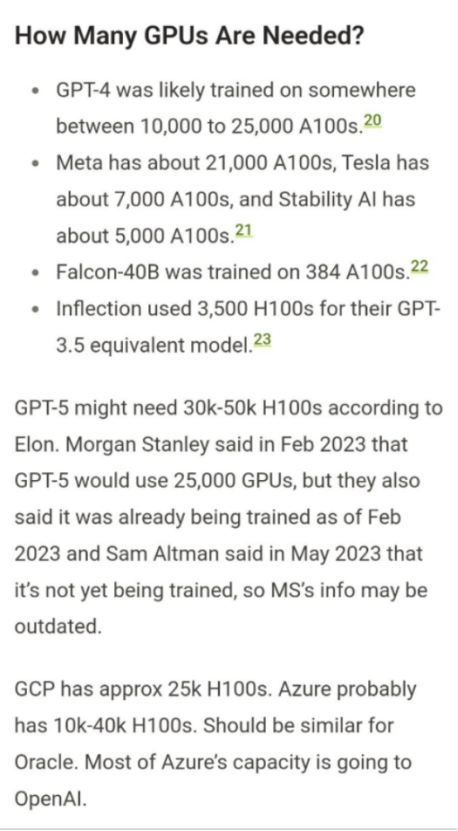

近来,社区广为流传的一张图「我们需要多少张 GPU」,引发了众多网友的讨论。

根据图中内容所示:GPT-4 可能在大约 10000—25000 张 A100 上进行训练;Meta 大约需要 21000 张 A100;Tesla 大约需要 7000 张 A100;Stability AI 大约需要 5000 张 A100;Falcon-40B 在 384 张 A100 上进行了训练;Inflection 使用了 3500 张 H100,来训练与 GPT-3.5 能力相当的模型。另外,根据马斯克的说法,GPT-5 可能需要 30000—50000 张 H100。

面对如此强大的需求,英伟达的 GPU 陷入极度短缺。据外媒报道,供应链消息显示,在生成式人工智能需求高涨以及国际形势变化等因素影响下,英伟达专供中国市场的 A800 和 H800 GPU 价格持续攀升。7 月中旬,英伟达代理商反馈,英伟达的 A800 GPU 单价涨至 12 万元,H800 和 H100 报价也都超过 20 万。目前英伟达订单能见度已至 2024 年,以现在的排产进度,就连 A800/H800 都要到今年底或明年才能交货。

产量瓶颈在哪里?

据 tomshardware 报道,英伟达 DGX 系统副总裁兼总经理 Charlie Boyle 出面澄清了该公司 GPU 产量问题的具体所在。Charlie Boyle 表示,问题并非来自英伟达错误计算需求,或其制造合作伙伴台积电的晶圆产量问题。相反,制造足够的 GPU 来满足消费者和专业工作负载(比如 AI)的瓶颈在于随后的芯片封装步骤。

英伟达的 H 系列 GPU 采用台积电的 2.5D CoWoS 封装技术,这是一种多步骤、高精度的工程流程,其复杂性降低了在给定时间内可以组装的 GPU 数量,这可能会不成比例地影响供应。马斯克也表示「GPU 超级难得」。

因此,当人们使用「GPU 短缺」这个词时,他们实际上是在谈论主板上某些组件的短缺或积压,而不是 GPU 本身。

在芯片成为可用的 GPU 之前,需要执行从芯片设计到制造的多个步骤。芯片设计阶段的问题可能会因设计疏忽而造成制造瓶颈,从而降低设计的良率。稀土金属或其他材料(例如最近受到限制的镓)的缺乏将影响长物流链中的其他步骤;材料污染、能源中断和许多其他因素也会造成影响。

但 CoWoS 的瓶颈问题可能比预想的更严重。台积电也表示,预计需要一年半(以及完成额外晶圆厂和扩建现有设施)才能使封装订单积压恢复正常。这可能意味着英伟达将不得不决定将哪些封装能力分配给哪些产品,因为它没有足够的时间和能力来封装所有产品。

不仅如此,为限制中国 AI 产业的发展,美国总统拜登在今年 8 月正式签署行政命令,限制美国企业未来在敏感技术的对华投资,涵盖半导体、量子计算和人工智能三大领域,预计将于明年实施。

产量不足尚且可破,倘若切断供应,极有可能使这些正在进行云端 AI 训练的大厂陷入困局,也正因此,这些科技巨头开始竞相囤积 A800 芯片。仍需重视的是,倘若 A800/H800 当真受到美国禁令的影响,中国本土芯片公司以及那些正在自研芯片的科技大厂是否有能力担此重任?

运行大模型,国产 GPGPU 有哪些可选标的?

如今,美国实施新的许可要求,限制中国利用高端 GPU 获取先进计算能力,由于被限制的是近两年商用领域最先进的 GPU 产品,暂时没有可以全面替代的选择。因此,美国政府认为,切断中国从美国公司获取这些芯片的直接渠道,可以为中国人工智能的发展制造障碍,迟滞中国人工智能的发展,希望中国人工智能领域由此一蹶不振。

然而事实呢?事实是禁令一出美国企业的股票遇冷下行,生产类似芯片的中国企业的股票却呈现相反的上行态势。这也意味着作为美国企业战略竞争者的中国企业或许能够获得更大的发展空间。

其实从 2019 年开始,应用于超算领域的高端 GPU 售至中国就受到严格管制,但当时只是 AMD 产品受限,英伟达的产品并未受到影响,因此企业和消费者在产品端的感知也并不强。而这一次范围扩大之后,其主要应用场景除了超算中心之外,还包括云计算服务器、数据中心、AI 训练等场景,许多互联网大厂也就受到了影响。

正因为有了前车之鉴,随着国内云计算以及互联网企业在云端存储、数据处理等方面需要的数据量越来越多,各大互联网公司、云厂商也在 AI 芯片领域进行布局。

2019 年阿里推出人工智能芯片「含光 800」,「含光 800」是一款面向数据中心 AI 应用的人工处理推理芯片,采用台积电 12nm 制程,这是一颗为 AI 场景深度定制的芯片,进一步提升了 AI 场景计算的效率。阿里曾表示,「含光 800」是当时全球最强的 AI 芯片,性能和能效比均为第一,1 颗「含光 800」的算力相当于 10 颗 GPU。目前已应用在阿里云的云服务器中,它能够优化电商智能搜索、智能营销等场景。阿里「含光 800」虽然不对外售卖,但阿里云智能总裁张建峰也提到「含光 800」将通过阿里云对外输出 AI 算力,未来企业可以通过阿里云获取「含光 800」的算力。

百度也在 2020 年量产了第一代 AI 芯片——昆仑。百度昆仑 1 采用三星 14nm 制程工艺,目前量产超过 2 万片,在百度搜索引擎和百度智能云生态伙伴等场景广泛部署。百度昆仑 2 于 2021 年下半年实现量产,采用 7nm 先进工艺,其性能比百度昆仑 1 再提升 3 倍。据悉,百度正在做第三款昆仑芯片,将于明年的年初上市。

稍微慢一点的腾讯也在 2021 年发布了视频处理芯片「沧海」和 AI 芯片「紫霄」。字节在「2022 火山引擎原动力大会」上也正式确认了其在自主造芯方面的布局。目前,字节的自研芯片已经涉足视频平台、信息和娱乐应用等。

目前为止,国内互联网大厂的芯片研发方向都集中在云计算、视频图像处理等方面的专用或者通用芯片上。除了互联网大厂,国内也已经有一些 GPU 厂商源源不断的发布一些性能优异的产品。

目前全球 AI 计算芯片主要分为 GPGPU、ASIC、FPGA 三种架构。而被限制的 A800 和 H800 芯片就属于 GPGPU 架构芯片。目前能运行大模型训练的也只有 GPGPU 架构。

当前国内 AI 芯片主要厂商包括华为、寒武纪、海光信息、遂原、壁仞、天数智芯等,此外龙芯也在布局。其中,发力 GPGPU 芯片的包括海光、壁仞科技、沐曦科技、龙芯等等。

海光的深算一号采用的就是 GPGPU 架构,是公司 DCU 系列的主要在售产品。

国内的厂商中海光信息从实际量产的技术上来讲是第一梯队,其深算一号可以用来运行大模型,在 2022 年度实现了在大数据处理、人工智能、商业计算等领域的商业化应用。不过其整体性能只相当于英伟达 P100 的水平,大约是英伟达 2014 年的技术水平。不过,其深算二号、三号也处于研发阶段,海光称其产品性能在国内处于领先地位。

壁仞科技在 2022 年发布了首款 GPGPU 芯片 BR100 系列,性能方面超越英伟达 A100。BR100 系列通用 GPU 芯片支持云端训练和推理,目前已经到了收尾阶段,正准备流片。壁仞科技的第二款芯片也已经开始启动架构设计,之后壁仞科技还将逐步推出面向智算中心、云游戏、边缘计算的 GPU 芯片。至于未来量产应用情况暂时存疑。还需重视的是,对于国内初创 GPGPU 公司而言,软件生态更为重要。目前国内的初创公司虽然在细分领域上有一定的落地,而真正在大模型训练上能有实际应用的还非常欠缺。倘若未来 BR100 的实际应用效果还不错,那么在软件生态上还需加把劲。

沐曦也是国内 GPGPU 的选手之一。沐曦公司旗下主要有曦思和曦云两款 AI 芯片,其中曦云 MXC 系列是该公司研发的用于 AI 训练及通用计算的 GPU 芯片。MXC500 是沐曦对标 A100/A800 的算力芯片,FP32 浮点性能可达 15TFlops,作为对比的是 A100 显卡 FP32 性能 19.5 TFLOPS。除了性能接近之外,MXC500 的完整软件栈(MXMACA)还兼容 CUDA,预计年底规模出货。

龙芯目前暂无产品发布,目前进展为已经完成相关 IP 的设计,正在验证优化过程中,第一个集成自研 GPGPU 核的 SOC 芯片计划于 2024 年 Q1 流片。从流片到量产,如果按最快 6—12 个月来算,龙芯的 GPGPU 产品至少也要在 2024 年 Q3 以后才能发布,量产估计需要在 2025 年了。

另外,华为昇腾也十分被看好。华为的昇腾 910 也能拿来当训练芯片,其算力强悍,超英伟达的 Tesla V100 一倍。但是由于昇腾 910 依赖华为自身软件生态、需要华为深度优化及代码移植,通用性相对要差一些,且其采用台积电的 7nm 制程,在制造上也受到限制,因此暂不做过多讨论。

英伟达是最优选,但不能视为唯一选

如今 GPU 缺口还在加速扩大,倘若 A800/H800 也受到供应限制,那么中国的云服务器厂商一定要提前谋划一条自主的发展路径。

中国 AI 芯片厂商正从原来强调算力和独特技术的倾向逐渐向针对特定应用场景而优化的方向转变。虽然微软、谷歌以及百度现在将 AI 拿来聊天画画,但不代表他们的 AI 不能做其他事情。当下让 AI 落地在民用市场不但能使厂商利用 AI 获得更多的收入,特别是微软、谷歌和百度都有不小的广告业务,另一方面让用户更直观的体验到 AI,在民用市场采集更多的数据进行训练亦能反哺云端场景的应用。这个过程可能会长一点,慢一点,但是这也是一定要做的事情。

同样,倘若无法与中国进行贸易,美国企业也要承受巨大损失。A800 和 H800 这些 GPU 就是英伟达为了绕过美国对中国施行的出口禁令所开发,以此维持其在中国市场的地位。英伟达此前透露,下半年他们能够供应更多的 GPU,但是没有提供任何定量的信息。英伟达首席财务官 Colette Kress 此前在 2023 年 2 月至 4 月的财报电话会议上透露:「我们正在处理本季度的供应,但我们也为下半年采购了大量生产材料。我们相信下半年的供应量将大大高于上半年。」

对于中国的市场现状来说,英伟达 GPU 确是最优选,但长久来看并不能将其视为唯一选。

评论