颠覆性的HBM4

一位业内人士表示,「『半导体游戏规则』可能在 10 年内改变,区别存储半导体和逻辑半导体可能变得毫无意义」。

本文引用地址:http://www.amcfsurvey.com/article/202312/453899.htmHBM4,魅力为何如此?

技术的突破

2023 年,在 AI 技术应用的推动下,数据呈现出爆炸式的增长,大幅度推升了算力需求。据悉,在 AI 大模型领域,未来 AI 服务器的主要需求将从训练侧向推理侧倾斜。而根据 IDC 的预测,到 2026 年,AIGC 的算力 62.2% 将作用于模型推理。同时,预计到 2025 年,智能算力需求将达到当前的 100 倍。

据悉,自 2015 年以来,从 HBM1 到 HBM3e 各种更新和改进中,HBM 在所有迭代中都保留了相同的 1024 位 (每个堆栈) 接口,即具有以相对适中的时钟速度运行的超宽接口。然而,随着内存传输速率要求不断提高,尤其是在 DRAM 单元的基础物理原理没有改变的情况下,这一速度将无法满足未来 AI 场景下的数据传输要求。为此,下一代 HBM4 需要对高带宽内存技术进行更实质性的改变,即从更宽的 2048 位内存接口开始。

接口宽度从每堆栈 1024 位增加到每堆栈 2048 位,将使得 HBM4 具备的变革意义。

当前,生成式人工智能已经成为推动 DRAM 市场增长的关键因素,与处理器一起处理数据的 HBM 的需求也必将增长。未来,随着 AI 技术不断演进,HBM 将成为数据中心的标准配置,而以企业应用为重点场景的存储卡供应商期望提供更快的接口。

根据 DigiTimes 援引 Seoul Economy 的消息:下一代 HBM4 内存堆栈将采用 2048 位内存接口。

将接口宽度从每堆栈 1024 位增加到每堆栈 2048 位将是 HBM 内存技术所见过的最大变化。自 2015 年以来,从 HBM1 到 HBM3e 各种更新和改进中,HBM 在所有迭代中都保留了相同的 1024 位 (每个堆栈) 接口。

采用 2048 位内存接口,理论上也可以使传输速度再次翻倍。例如,英伟达的旗舰 Hopper H100 GPU,搭配的六颗 HBM3 达到 6144-bit 位宽。如果内存接口翻倍到 2048 位,英伟达理论上可以将芯片数量减半到三个,并获得相同的性能。

回顾 HBM 发展历史,由于物理限制,使用 HBM1 的显卡的内存上限为 4GB。然而,随着时间的推移,SK 海力士和三星等 HBM 制造商已经改进了 HBM 的缺点。

HBM2 将潜在速度提高了一倍,达到每个堆栈 256GB/s,最大容量达到 8GB。2018 年,HBM2 进行了一次名为 HBM2E 的小更新,进一步将容量限制提高到 24GB,并带来了另一次速度提升,最终达到峰值时的每芯片 460GB/s。

当 HBM3 推出时,速度又翻了一番,允许每个堆栈最大 819GB/s。更令人印象深刻的是,容量增加了近三倍,从 24GB 增加到 64GB。和 HBM2E 一样,HBM3 看到了另一个中期升级,HBM3E,它将理论速度提高到每堆栈 1.2 TB/s。

在此过程中,HBM 在消费级显卡中逐渐被更便宜的 GDDR 内存所取代。HBM 越发成为成为数据中心的标准配置,以企业应用为重点场景的存储卡供应商们期望提供更快的接口。

有机遇就有挑战

目前,HBM 主要是放置 CPU/GPU 的中介层上,并使用 1024bit 接口连接到逻辑芯片。SK 海力士目标是将 HBM4 直接堆叠在逻辑芯片上,完全消除中介层。HBM4 很可能与现有半导体完全不同,散热问题也随之而来。因此,要想为逻辑+存储这一集成体散热,可能需要非常复杂的方法,液冷和浸没式散热或是解决方案。

HBM 主要是通过硅通孔技术进行芯片堆叠,以增加吞吐量并克服单一封装内带宽的限制,将数个 DRAM 裸片像楼层一样垂直堆叠。在 HBM4 技术实现上,一个模块中堆叠更多的内存芯片的技术复杂性必然将进一步提高,主要难题在于需要增加硅通孔数量并缩小凸块间距。

例如为了生产 HBM4 内存堆栈(包括 16-Hi 堆栈),三星需要完善 SangJoon Hwang 提到的几项新技术。其中一项技术称为 NCF(非导电薄膜),是一种聚合物层,可保护 TSV 的焊接点免受绝缘和机械冲击。另一种是 HCB(混合铜键合),这是一种键合技术,使用铜导体和氧化膜绝缘体代替传统焊料,以最大限度地减少 DRAM 器件之间的距离,并实现 2048 位接口所需的更小的凸块。这不是一项简单的工作。

入局

三星电子的技术团队执行副总裁兼 DRAM 产品主管 SangJoon Hwang 在公司博客文章中写道「展望未来,HBM4 预计将于 2025 年推出,其技术针对正在开发的高热性能进行了优化,例如非导电薄膜 (NCF) 组装和混合铜接合 (HCB),」。

尽管三星预计 HBM4 将于 2025 年推出,但其生产可能会在 2025-2026 年开始,因为业界需要为该技术做大量准备。与此同时,三星将为客户提供数据传输速率为 9.8 GT/s 的 HBM3E 内存堆栈,每个堆栈的带宽为 1.25 TB/s。

在封装技术方面,三星采用了无凸点键合技术。无凸点键合是一种先进的封装技术,它将芯片与芯片之间直接进行连接,无需使用传统的微凸点键合。这种技术可以显著提高内存的 I/O 速度和可靠性,同时降低了制造成本。

三星在无凸点键合技术上的突破得益于其在封装领域的深厚积累和技术积累。通过不断研发和创新,三星成功地将无凸点键合技术应用到 HBM4 内存的生产中,实现了铜层与铜层之间的直接互连。这种直接互连的方式可以大幅度提高内存的传输速度和稳定性,同时降低了功耗。

三星在 HBM4 内存技术的发展中展现了强大的研发实力和技术创新能力。通过工艺学习和封装技术的创新,三星成功地将 FinFET 立体晶体管和无凸点键合技术应用到 HBM4 内存的生产中。这些新技术的应用使得 HBM4 内存具有更高的性能、更低的功耗和更低的制造成本。

今年早些时候,美光透露「HBMNext」内存将于 2026 年左右出现,提供 32GB 至 64GB 之间的每堆栈容量以及每堆栈 2 TB/s 或更高的峰值带宽,较 HBM3E 的每堆栈 1.2 TB/s 显着增加。要构建 64GB 堆栈,需要具有 32GB 内存设备的 16-Hi 堆栈。尽管 HBM3 规范也支持 16-Hi 堆栈,但到目前为止还没有人宣布此类产品,而且看起来如此密集的堆栈只会通过 HBM4 进入市场。

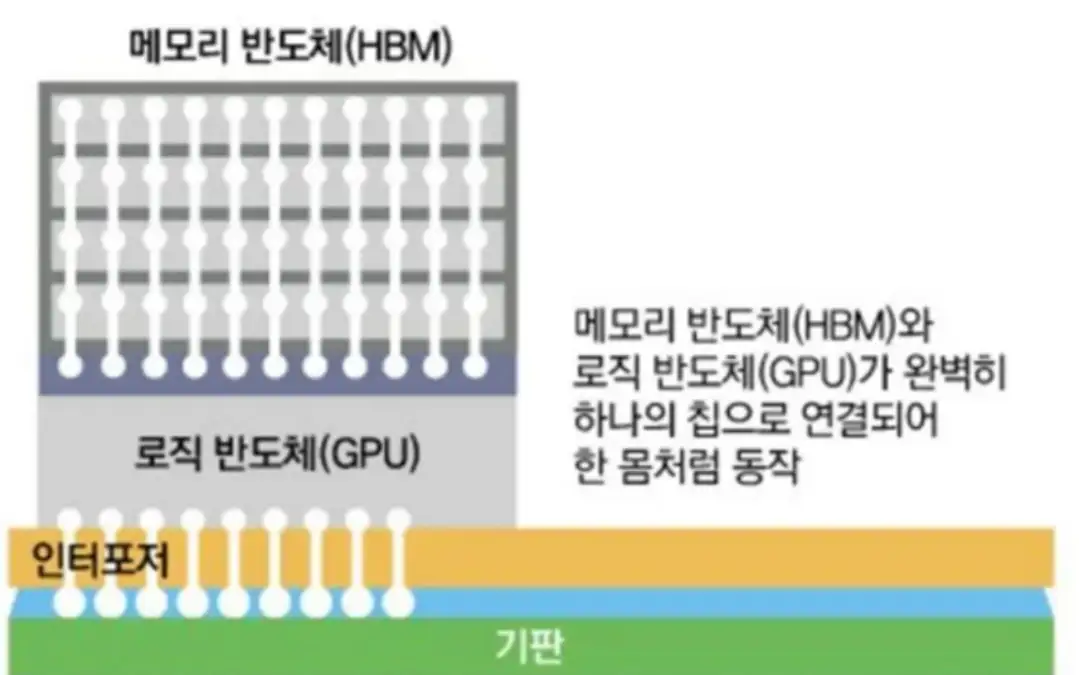

11 月,据韩媒中央日报(Joongang.co.kr)报道,韩国内存芯片大厂 SK 海力士正计划携手英伟达(NVIDIA)开发全新的 GPU,拟将其新一代的高带宽內存(HBM4)与逻辑芯片堆叠在一起,这也将是业界首创。SK 海力士已与英伟达等半导体公司针对该项目进行合作,据报道当中的先进封装技术有望委托台积电,作为首选代工厂。

SK 海力士目标是将未来的 HBM4 以 3D 堆叠的形式堆叠在英伟达、AMD 等公司的逻辑芯片上,预计该 HBM4 内存堆栈将采用 2048 位接口。

图:SK 海力士 HBM4 计划连接方式(来源:韩国中央日报)

外媒 Tom』s Hardware 指出,这种设计与 AMD V-Cache 类似,后者将一小块 L3 缓存(cache)直接放在 CPU 顶部,新技术则是则将 GPU 所有 HBM 內存放在 GPU 顶部或几个芯片的顶部。

这种技术优点是缩小封装尺寸、提高容量和性能,但散热将是最大问题。比如采用 V-Cache 的 AMD CPU,必须降低 TDP 和主频,以补偿 3D cache 产生的额外热量,像英伟达 H100 这种数据中心 GPU,需要 80-96GB 的 HBM,在容量和热量与 V-cache 完全难比拟。现在一块计算中心计算卡的功耗可能是几百瓦,即便只是 HBM 部分也相当耗电,要做好散热可能需要非常复杂的方式。

另外,选择这种集成方法也将改变芯片的设计和制造方式,存储器与逻辑芯片将采用相同的工艺技术,而且会在同一间晶圆厂生产,确保最终的性能。如果仅考虑 DRAM 的成本,那么确实会有较大幅度的增长,所以各方都还没有真正认真考虑这一方案。

据了解,SK 海力士正在与包括英伟达在内的芯片设计公司讨论 HBM4 集成设计方案。SK 海力士和英伟达可能从一开始就进行了合作,而且会选择在台积电生产,将使用晶圆键合技术将 SK 海力士的 HBM4 堆叠在逻辑芯片上。

此前,SK 海力士的一位负责人曾强调,「最关键的作用是制造工厂(FAB)和封装部门之间的紧密沟通,因为 HBM 需要在后处理方面进行先发制人的投资。」他补充道:「SK 海力士已经能够开发出与竞争对手不同的封装技术,并从合作伙伴那里获得长期独家的关键材料。」

面对三星的竞争,SK 海力士并不担心。「虽然三星电子可以通过同时提供存储器和逻辑芯片工艺来引领 HBM 领域。」但 SK 海力士的一位负责人表示,「客户不希望一家公司占据主导地位,他们目前重视英伟达、台积电和 SK 海力士之间的合作。」

评论